Googleがプロプライエタリとオープンソースの2つの新しいツール、AI HubとKubeflow Pipelinesを立ち上げている。どちらも、データサイエンティストが機械学習アルゴリズムを設計、立ち上げ、追跡するのを支援するものだ。

AI HubとKubeflow Pipelinesにより、Googleは1月のCloud AutoMLのリリースに続いて、顧客がGoogleのAI技術とサービスをシンプルに迅速に導入するための戦略を進めている。Cloud ML PlatformのエンジニアリングディレクターであるHussein Mehanna氏はブログに次のように書いている。

私たちGoogleの目標は、AIをすべての企業にとって手の届くものにすることです。しかし、そのためには参入の敷居を下げなければなりません。そこで私たちは、3つのことを念頭に置いてすべてのAIサービスを構築しています。それは、「より多くの企業が導入できるようにシンプルにすること」「できるだけ多様な組織にとって便利なものにすること」「企業がより迅速に導入でき、繰り返し利用して成功を収められるように高速化すること」です。

GoogleはAI Hubを導入することで、既存のツールや成果を容易に発見、共有、再利用できるようにして、AIをもっと企業にとって手の届くものにする。さらにAI Hubは、パイプライン、Jupyter notebooks、TensorFlowモジュールといった機械学習コンテンツが1か所に集まる場になる。

- Google Cloud AIやGoogle Research、Google社内のチームが開発した高品質な機械学習リソースは、すべての企業が自由にアクセスできる。

- Googleは、企業が機械学習リソースをアップロードして社内だけで共有できるプライベートで安全なハブを提供する。このハブにより、企業はほんの数ステップで、GCP(もしくはKubeflow Pipelinesシステムを使用したハイブリッドインフラストラクチャ)でパイプラインを再利用し、本番環境にデプロイすることができる。

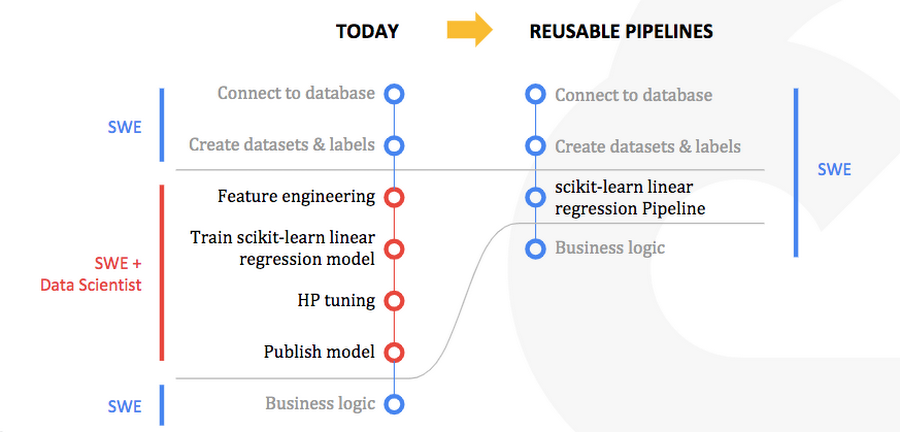

次にGoogleは、組織が機械学習リソースを発見、共有、再利用できる中心的な場として、Kubeflow Pipelinesを使って機械学習リソースを構築し、パッケージ化できるようにする。Kubeflow Pipelinesは、機械学習のためにKubernetes上に開発されたオープンソースフレームワークKubeflowの拡張だ。パイプラインは基本的にコンテナ化されたブロックであり、ユーザーはそれらをつなぎ合わせることで、機械学習ワークフローを構築、管理することができる。

画像のソース: Google Cloud Blog

基本的に、Kubeflow Pipelinesはオープンソースのワークベンチソリューションであり、ユーザーは機械学習ワークフローの構成、デプロイ、管理を行うことができる。そして、モデルを本番環境にデプロイする前に実験するための相互運用性と柔軟性を提供する。

さらにMehanna氏はブログに次のように書いている。

CiscoやNVIDIAのような企業は、このオープンソースプロジェクトの主要なコントリビューターであり、私たちはこれらの企業と密接に協力し、Kubeflow Pipelinesの導入を進めています。NVIDIAはすでに、オープンソースの新しいデータサイエンスライブラリスイートであるRAPIDSをKubeflowに統合しつつあります。RAPIDSライブラリはGPUを活用してデータの前処理や機械学習を劇的にスピードアップするなど、Kubeflowに対する補完性に優れています。

AI HubとKubeflow Pipelinesはどちらも、データサイエンティストが組織全体でモデルを共有しやすくするものだ。また、これらツールのアーリーアダプターはかなり大きな機械学習/データサイエンス部門を持つ組織で、Cloud AIのプロダクトマネジメント担当ディレクターであるRajen Sheth氏によると、小売、金融サービス、製造、医療、メディアといった業種の企業になると思われる。

Rate this Article

- Editor Review

- Chief Editor Action