最近AmazonはAWSディープラーニングコンテナ(AWS DLコンテナ)を発表した。それはディープラーニングフレームワークがプレインストールされたDockerイメージであり、顧客はカスタムの機械学習環境を迅速にデプロイできる。

AWS DLコンテナは、Amazon EKSとECSを定期的に使用してTensorFlowワークロードをクラウドにデプロイする顧客向けに「直接的な価値を生まない高負荷な作業」を取り除くためにAmazonによって作成された。Amazonはまた、トレーニング時間を短縮し、推論パフォーマンスを向上させるために、AWSで使用するイメージを最適化した。Jeff Barrがブログ投稿で次の通りAWS DLコンテナを紹介した。

ディープラーニングに集中できるようにイメージは事前設定および検証されており、Amazon ECS、Kubernetes向けAmazon Elastic Container Service、およびAmazon Elastic Compute Cloud(EC2)でのカスタム環境とワークフローを数分でセットアップします!

AWS DLコンテナは現在TensorFlowとApache MXNetをサポートする予定であると共に、FacebookのPyTorchのような他のフレームワークもそれに続く。AWSのディープラーニングおよびAI担当ゼネラルマネジャーであるMatt Wood博士は、サンタクララで開催されたAWSサミットのステージ上で次のように述べている。

これらすべてのフレームワークの構築、コンパイル、生成、設定、最適化という面倒な作業はすべて完了しているので、そういった作業をする必要はありません。そして、それはあなたがこれらの非常に非常に複雑なフレームワークをインストールしてからそれらを維持するという直接的な価値を生まない高負荷な作業を少なくすることを意味します。

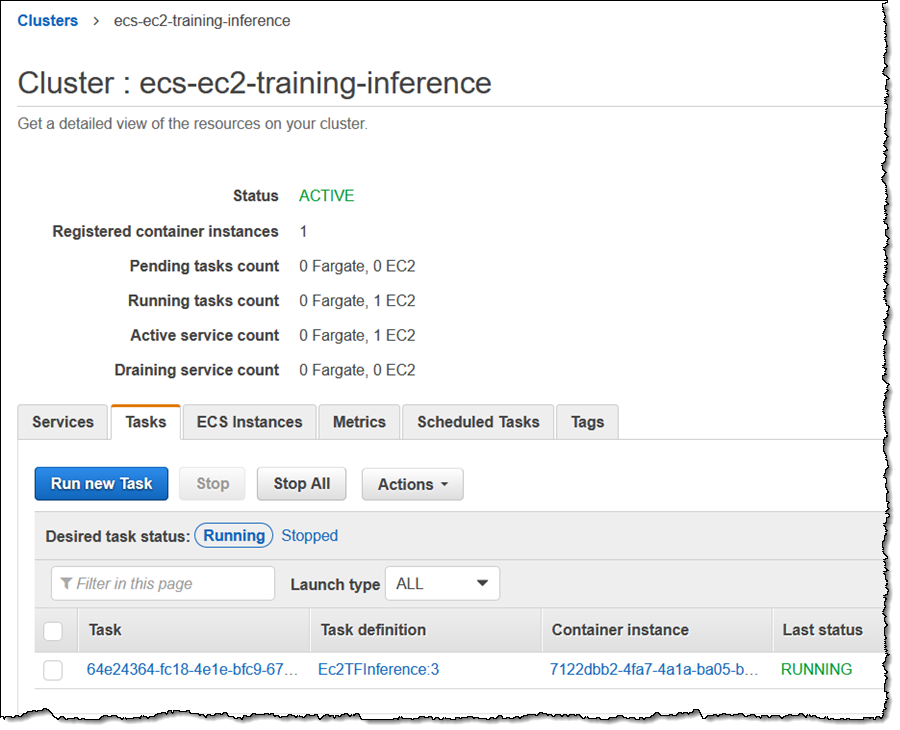

ディープラーニングコンテナの一般的なデプロイは、開発者が特定のインスタンスサイズでECSクラスタを作成することから始まる。クラスタが実行され、コンテナエージェントがアクティブになると、開発者はコンテナの仕様を含むタスク定義を登録できる。仕様には、フレームワーク(TensorFlowまたはMXNet)、モード(トレーニングまたは推論)、環境(CPUまたはGPU)、他のファクタが含まれる。登録により、開発者はリビジョン番号を取得し、この番号とタスク定義を使用してサービスを作成する。最後に、開発者はAWSコンソールを介して、タスクにアクセスして干渉することができる。

ソース: https://aws.amazon.com/blogs/aws/new-aws-deep-learning-containers/

最近、さまざまな大手パブリッククラウドプロバイダが、クラウド用の機械学習(ML)機能の提供に積極的に取り組んでいる。AmazonのAWS DLコンテナと他の最近利用可能になったElastic Inference Engineサービスはその一例である。さらに、マイクロソフトはGPUで処理が高速化された機械学習機能を提供するようになり、GoogleはクラウドプラットフォームでTensorflow 2.0をサポートするようになった。

AWS DLコンテナは、Amazon Elastic Container Registry(Amazon ECR)およびAWS Marketplaceから無料で入手できる。顧客は使用するリソースに対してのみ料金を支払う。