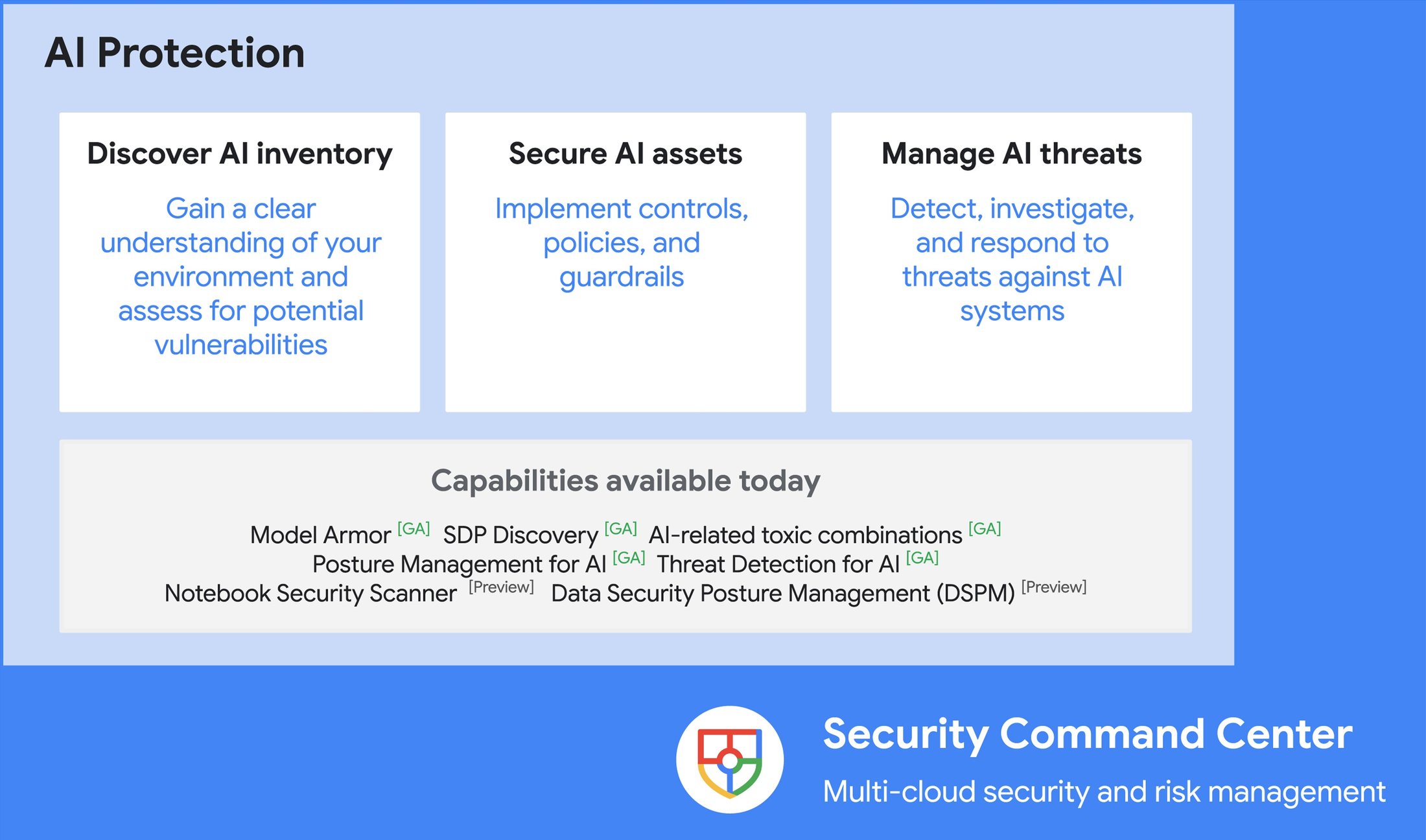

Google Cloudは最近、生成AIに関連するリスクや脅威から保護する包括的なソリューション、AI Protectionを発表した。

同社によるとAI Protectionは、AIインベントリを発見し、潜在的な脆弱性を評価することで、チームが効果的にAIリスクを管理できるよう支援する。さらにAIアセットを保護するためのコントロールとポリシーを実装することで、セキュリティを強化する。最終的に堅牢な検出と対応機能を通じてプロアクティブな脅威管理を可能にし、AIシステムに関連するリスクを管理する包括的なアプローチを実現する。

このソリューションはGoogleのSecurity Command Center(SCC)と統合され、ユーザーにITポスチャーの一元的なビューを提供し、他のクラウドリスクのコンテキストでAIリスクを管理する。

(出典:Google Cloud Newsブログ記事)

同社はサイバーセキュリティ予測レポートの主要な調査結果の1つとして、このソリューションを顧客に提供している:

攻撃者による人工知能(AI)の利用:脅威アクターは高度なフィッシング、ビッシング、ソーシャルエンジニアリング攻撃にAIをますます利用するようになるでしょう。また、なりすまし、詐欺、セキュリティ対策回避のためにディープフェイクを活用するようになるでしょう。

さらに、プリンシパルソリューションコンサルタント Mahmoud Rabie氏は、AI Protectionが重要な理由をLinkedInに投稿した:

AIモデルはクリティカルなアプリケーションにますますデプロイされており、サイバー脅威の格好の標的になっています。データポイズニング、敵対的攻撃、モデル流出などのセキュリティリスクは重大な課題をもたらします。

同社は、効果的なAIリスク管理にはAIアセットとその関係を理解し、AIアプリケーション内の機密データを特定・保護することが含まれると考えている。AI Protectionツールはデータの発見を自動化し、仮想レッドチーミングを使用して脆弱性を検出し、セキュリティポスチャを強化するための改善策を提案する。

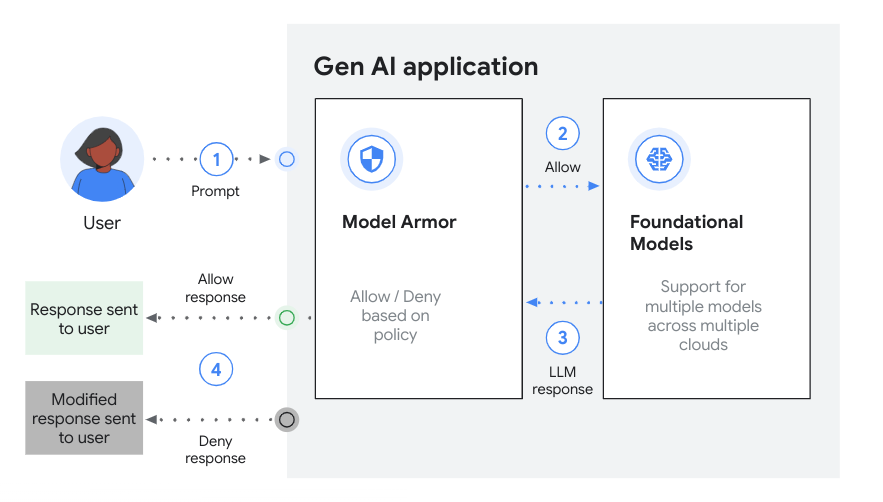

AIアセットを理解することの次はそれらを保護することである。AIアセットを保護するためにAI ProtectionはModel Armorを利用する。Model Armorはセキュリティおよび安全性リスクに対してプロンプトと応答をスクリーニングすることにより、AIアプリケーションのセキュリティと安全性を強化するフルマネージドサービスです。

(出典:Google Cloud Newsブログ記事)

Model Armorに関するMediumのブログ投稿で、Sasha Heyer氏はこう結論付けている:

Model Armorは生成AIアプリケーションのセキュリティを強化する素晴らしい製品です。プロンプトインジェクション、データ漏洩、悪意のあるコンテンツの防止に役立ちます。しかし既存のVertex AI 生成AIスタックとの直接的な統合が欠けているため、開発者は手作業でワークフローに統合する必要があります。

最後に、AI ProtectionはGoogleとMandiantの高度なセキュリティインテリジェンスと研究を活用し、顧客のAIシステムを効果的に保護する。Security Command Centerの検出機能は、AIワークロードに関連する初期アクセスの試み、特権昇格、永続化の取り組みを特定する上で重要な役割を果たす。セキュリティ課題の最前線に立ち続けることを約束し、同社はまもなくAI Protectionに基盤モデルの乗っ取りを含むランタイムの脅威を認識し、管理するように設計された新しい検出機能を導入する。